- 세미나 정보

- 논문 제목: V3: Viewing Volumetric Videos on Mobiles via Streamable 2D Dynamic Gaussians_SIGGRAPHAsia2024, ACM Transactions on Graphics (TOG)

- 발표자: shahn | 일시: 2024.01.24(금) | 장소: MCSLab

- 서론

- 고품질의 볼류메트릭 비디오를 2D 비디오처럼 원활하게 경험하는 것은 오랫동안 추구해온 목표입니다. 그러나 현재의 동적 3D Gaussian Splatting(3DGS) 방법들은 높은 렌더링 품질에도 불구하고, 모바일 장치에서의 스트리밍에 있어 계산 및 대역폭 제약으로 인해 어려움을 겪고 있습니다. 이 논문에서는 동적 가우시안을 스트리밍하여 고품질의 모바일 렌더링을 가능하게 하는 새로운 접근법인 V³(Viewing Volumetric Videos)를 소개합니다. 핵심 혁신은 동적 3DGS를 2D 비디오로 간주하여 하드웨어 비디오 코덱의 활용을 촉진하는 것입니다.

- 연구 배경

- 기존의 동적 3DGS 방법들은 높은 렌더링 품질을 제공하지만, 모바일 장치에서의 스트리밍에는 계산 및 대역폭 제약으로 인해 한계가 있습니다. 특히, 긴 시퀀스의 경우 각 프레임에 대한 저장 요구 사항이 커서 스트리밍에 어려움이 있습니다. 또한, 모바일 장치의 하드웨어(CPU) 한계로 인해 복잡한 3D 데이터를 효율적으로 디코딩하고 렌더링하는 데 제약이 있습니다.

- 연구 목적

- 이 연구의 목적은 동적 3DGS를 2D 비디오(2D 그리드 가우시안 표현)로 변환하여 GPU의 하드웨어 비디오 코덱을 활용함으로써, 모바일 장치에서 고품질의 볼류메트릭 비디오 스트리밍을 가능하게 하는 것입니다. 이를 통해 사용자들은 다양한 장치에서 원활한 볼류메트릭 비디오 시청 경험을 누릴 수 있습니다.

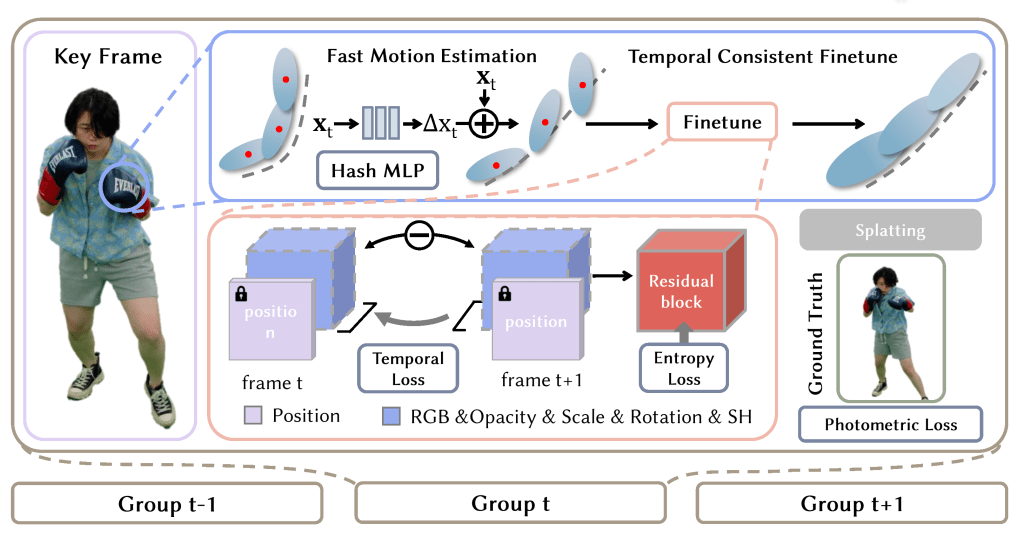

- 연구 방법

- 연구는 두 단계의 학습 전략을 제안합니다. 첫 번째 단계에서는 해시 인코딩과 얕은 MLP(Shallow neural network: 은닉층이 하나만 있는 인공신경망)를 사용하여 모션을 학습하고, 가우시안의 수를 줄여 스트리밍 요구 사항을 충족시킵니다. 두 번째 단계에서는 잔여 엔트로피 손실(residual entropy loss)과 시간적 손실(temporal loss)을 사용하여 다른 가우시안 속성을 미세 조정하고 시간적 연속성을 향상시킵니다. 이러한 전략은 모션과 외형을 분리하여 저장 요구 사항을 최소화하면서도 높은 렌더링 품질을 유지합니다.

- 🌱손실 함수(Loss Function)는 머신러닝과 딥러닝에서 모델의 예측 값과 실제 값 간의 차이를 측정하는 함수입니다. 이 때 ‘손실’이라는 용어는 모델의 성능이 얼마나 ‘나쁜지’를 나타내는 지표로 사용됩니다. 손실 함수의 값이 클수록 모델의 예측이 실제 값과 많이 다르다는 의미이며, 값이 작을수록 예측이 정확함을 나타냅니다. 따라서, 학습 과정에서는 이 손실 값을 최소화하는 방향으로 모델의 파라미터를 조정하게 됩니다.

- 방법론

- 동적 3DGS를 2D 비디오로 변환하여 하드웨어 비디오 코덱을 활용합니다. 각 프레임은 특정 3DGS 속성에 해당하며, 렌더링 시 각 픽셀에서 가우시안 속성을 추출하여 가우시안 스플랫 구조를 복원합니다.

- 데이터 수집

- ReRF, HiFi4G, HumanRF 등의 멀티뷰 인간 중심 데이터셋을 사용합니다.

- 다중 뷰 비디오 영상을 사용하여 2D 동적 가우시안 표현을 학습합니다. 긴 시퀀스를 처리하기 위해 전체 시퀀스를 프레임 그룹으로 분할하고, 각 그룹 내에서 프레임별로 순차 학습을 수행합니다.

- 연구는 두 단계의 학습 전략을 제안합니다. 첫 번째 단계에서는 해시 인코딩과 얕은 MLP(Shallow neural network: 은닉층이 하나만 있는 인공신경망)를 사용하여 모션을 학습하고, 가우시안의 수를 줄여 스트리밍 요구 사항을 충족시킵니다. 두 번째 단계에서는 잔여 엔트로피 손실(residual entropy loss)과 시간적 손실(temporal loss)을 사용하여 다른 가우시안 속성을 미세 조정하고 시간적 연속성을 향상시킵니다. 이러한 전략은 모션과 외형을 분리하여 저장 요구 사항을 최소화하면서도 높은 렌더링 품질을 유지합니다.

- 연구 결과

- 제안된 V³ 시스템은 기존 방법들보다 우수한 성능을 보이며, 일반적인 장치에서 고품질의 렌더링과 스트리밍을 가능하게 합니다. 이는 이전에는 볼 수 없었던 수준의 성능입니다.

- 주요 발견

- V³는 동적 가우시안을 2D 비디오로 변환하여 하드웨어 비디오 코덱을 활용함으로써, 모바일 장치에서 고품질의 볼류메트릭 비디오 스트리밍을 가능하게 합니다. 또한, 제안된 두 단계의 학습 전략은 저장 요구 사항을 최소화하면서도 높은 렌더링 품질을 유지합니다.

- 데이터 표현

- 가우시안 속성은 2D 비디오의 각 픽셀에 매핑되며, 렌더링 시 각 픽셀에서 3D 가우시안 속성을 추출하여 가우시안 스플랫 구조를 복원합니다.

- 결론 및 논의

- V³는 동적 3DGS를 2D 비디오로 변환하여 하드웨어 비디오 코덱을 활용함으로써, 모바일 장치에서 고품질의 볼류메트릭 비디오 스트리밍을 가능하게 합니다. 제안된 두 단계의 학습 전략은 모션과 외형을 분리하여 저장 요구 사항을 최소화하면서도 높은 렌더링 품질을 유지합니다. 또한, 멀티플랫폼 플레이어를 개발하여 다양한 장치에서의 호환성을 높였습니다.

- 결론

- V³는 동적 3DGS를 2D 비디오로 변환하여 하드웨어 비디오 코덱을 활용함으로써, 모바일 장치에서 고품질의 볼류메트릭 비디오 스트리밍을 가능하게 합니다. 이는 사용자들에게 다양한 장치에서 원활한 볼류메트릭 비디오 시청 경험을 제공합니다.

- 한계점

- 데이터셋 다양성의 제한: 제안된 방법은 특정 유형의 데이터셋, 특히 인간 중심의 멀티뷰 비디오에 대해 평가되었습니다. 따라서 다양한 주제나 복잡한 배경을 포함하는 데이터셋에 대한 일반화 가능성은 추가적인 검증이 필요합니다.

- 모바일 장치의 성능 제약: 비록 하드웨어 비디오 코덱을 활용하여 효율적인 스트리밍을 구현하였지만, 일부 저사양 모바일 장치에서는 디코딩 및 렌더링 과정에서 성능 저하나 지연이 발생할 수 있습니다.

- 실시간 상호작용의 한계: 현재 시스템은 사전 녹화된 볼류메트릭 비디오의 스트리밍에 중점을 두고 있으며, 실시간 상호작용이나 라이브 스트리밍 기능은 추가적인 연구와 개발이 필요합니다.

- 생각과 질문

- ‘모션과 외형을 어떻게 분리하는 것인가?’

- ‘아직 기존의 2D 비디오 코덱을 활용하는 방법이 일반적이군’

- 차세대 코덱인 H.266(VVC)와 AV2가 개발되고 있음. 주로 2D 비디오의 압축 효율을 높이기 위해 개발되고 있으나 H.266은 360도 비디오와 같은 VR 콘텐츠를 지원하도록 설계되어있음 (2D/3D/4D 비디오 코덱 발전 동향 궁금)

- 본 논문의 방법으로 연구실에서 취득한 멀티뷰 볼류메트릭 비디오를 모바일 기기에서 보기 (iOS 뷰어/SIBR 뷰)

- 참고 자료

- 관련 문헌

- 3D Gaussian Splatting for Real-Time Radiance Field Rendering _SIGGRAPH 2023, ACM Transactions on Graphics (TOG)

- https://repo-sam.inria.fr/fungraph/3d-gaussian-splatting/

- 이 연구는 3D 가우시안 스플랫팅을 활용하여 실시간으로 고품질의 방사 필드 렌더링을 구현하는 방법을 제시합니다. 본 논문의 핵심 기술적 기반이 되는 연구로, 3DGS의 효율성과 렌더링 품질을 입증하였습니다.

- Motion-Aware 3D Gaussian Splatting for Efficient Dynamic Scene Reconstruction

- 이 논문은 동적 장면의 효율적인 재구성을 위해 모션 인식 3D 가우시안 스플랫팅 기법을 소개합니다. 모션 정보를 효과적으로 활용하여 동적 3DGS의 성능을 향상시키는 방법을 다루고 있습니다.

- Superpoint Gaussian Splatting for Real-Time High-Fidelity Dynamic Scene Reconstruction

- 이 연구는 슈퍼포인트 표현을 통해 동적 장면의 고품질 실시간 재구성을 구현하는 방법을 제안합니다. 3D 가우시안 스플랫팅의 확장으로서, 동적 장면의 렌더링 품질과 효율성을 높이는 데 기여합니다.

- 3D Gaussian Splatting for Real-Time Radiance Field Rendering _SIGGRAPH 2023, ACM Transactions on Graphics (TOG)

- 링크

- 관련 문헌

Leave a comment